Алгоритмическая выпуклая оптимизация

- Автор:

Нестеров, Юрий Евгеньевич

- Шифр специальности:

01.01.07

- Научная степень:

Докторская

- Год защиты:

2013

- Место защиты:

Москва

- Количество страниц:

367 с.

Стоимость:

700 р.250 руб.

до окончания действия скидки

00

00

00

00

+

Наш сайт выгодно отличается тем что при покупке, кроме PDF версии Вы в подарок получаете работу преобразованную в WORD - документ и это предоставляет качественно другие возможности при работе с документом

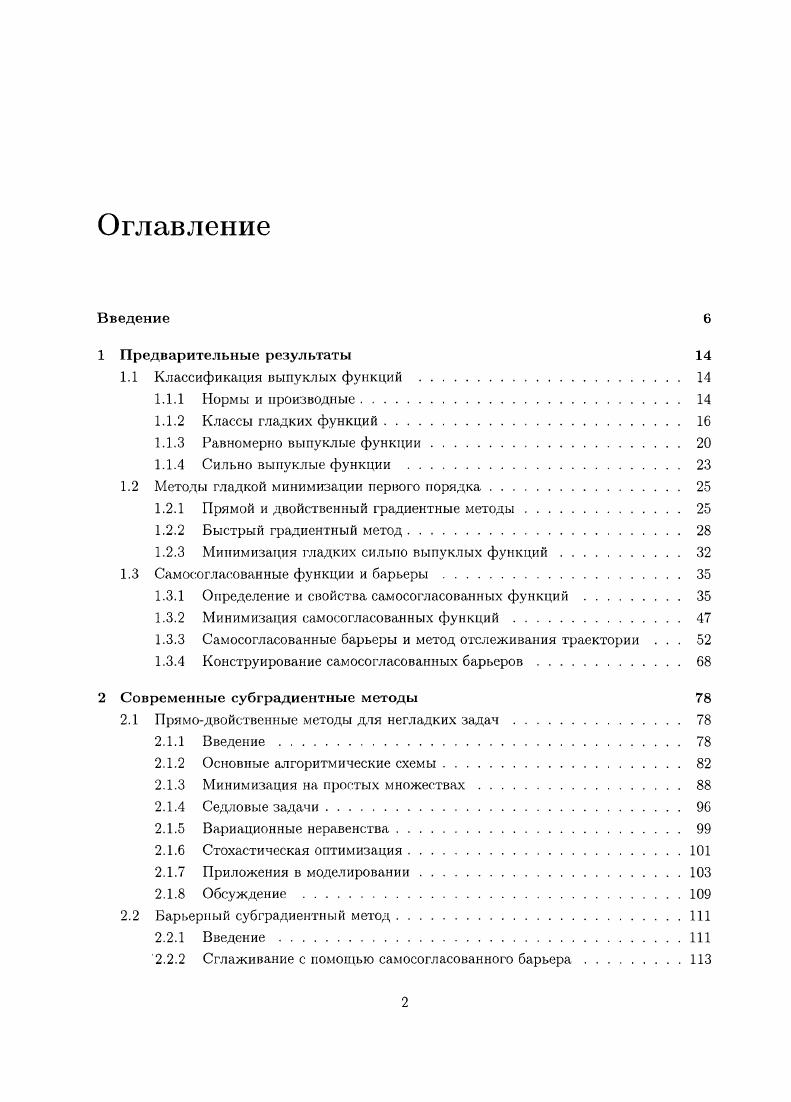

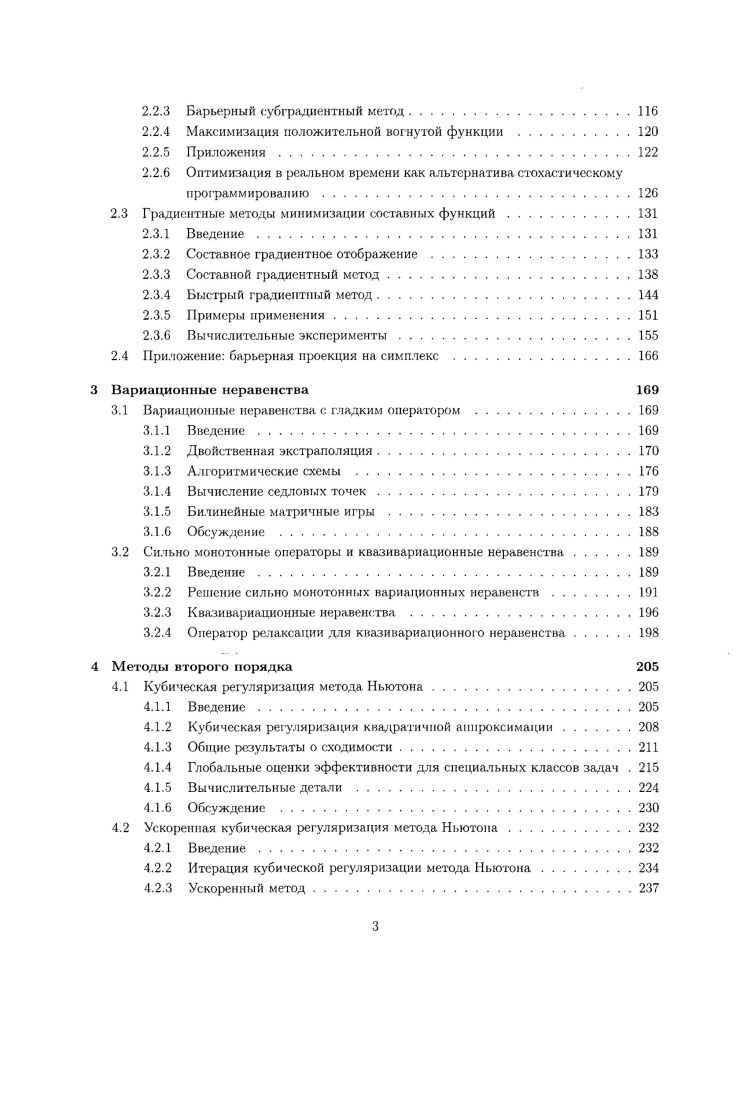

Страницы оглавления работы

Рекомендуемые диссертации данного раздела

| Название работы | Автор | Дата защиты |

|---|---|---|

| Численные методы решения краевых задач для линейных ОДУ второго порядка с малым параметром при старшей производной | Федоров, Дмитрий Владимирович | 2004 |

| О решении некоторых задач моделирования крупномасштабной динамики океана | Сухов, Владимир Борисович | 2009 |

| Одномерные вариационные и полностью консервативные разностные схемы МГД в смешанных эйлерово-лагранжевых переменных | Сороковикова, Ольга Спартаковна | 1984 |