Неравенства концентрации вероятностной меры в трансдуктивном обучении и РАС-Байесовском анализе

- Автор:

Толстихин, Илья Олегович

- Шифр специальности:

05.13.17

- Научная степень:

Кандидатская

- Год защиты:

2014

- Место защиты:

Москва

- Количество страниц:

201 с. : ил.

Стоимость:

700 р.250 руб.

до окончания действия скидки

00

00

00

00

+

Наш сайт выгодно отличается тем что при покупке, кроме PDF версии Вы в подарок получаете работу преобразованную в WORD - документ и это предоставляет качественно другие возможности при работе с документом

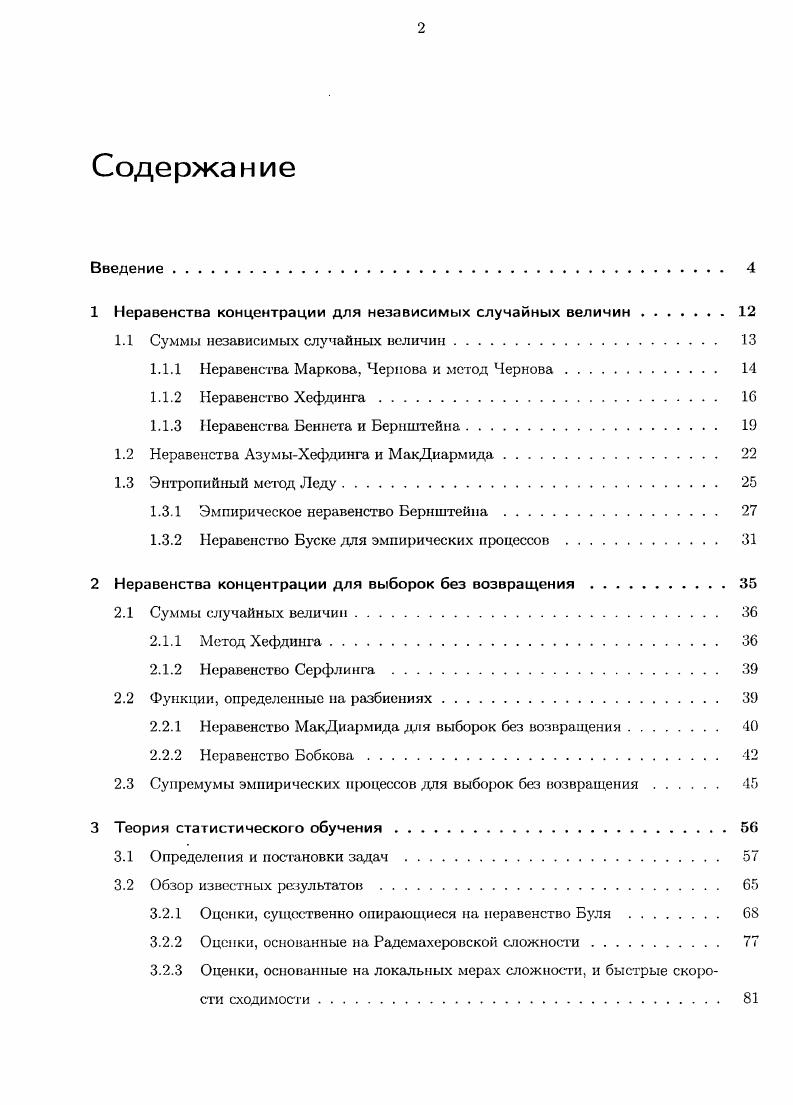

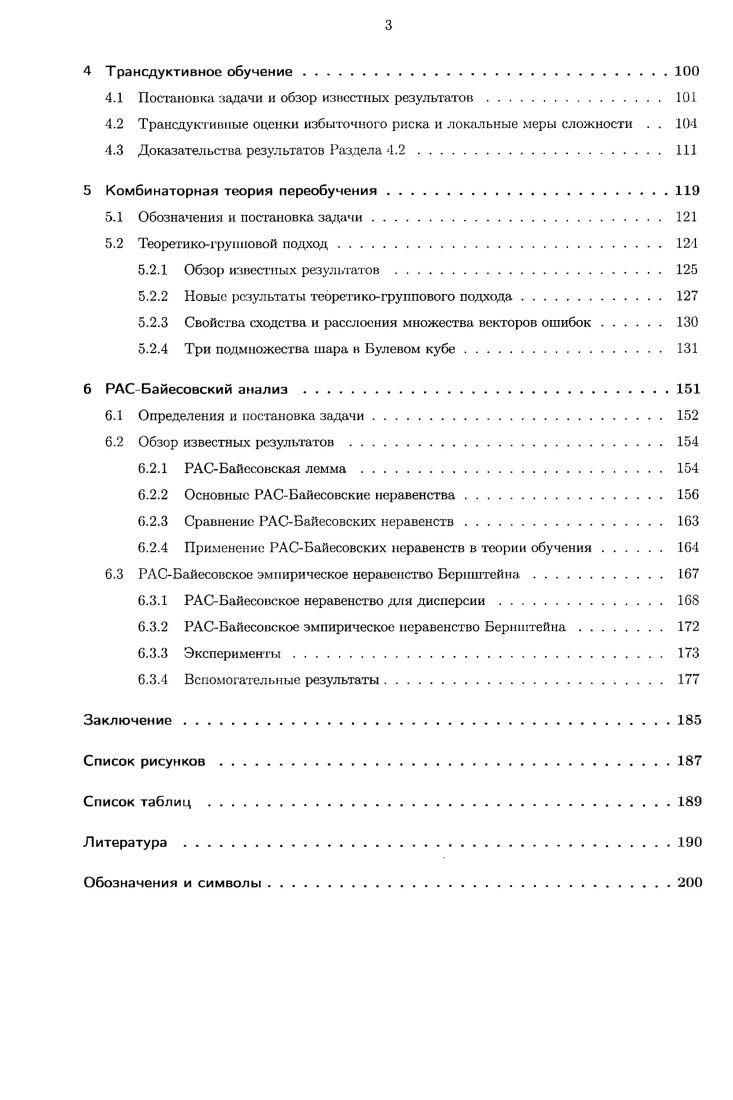

Страницы оглавления работы

Рекомендуемые диссертации данного раздела

| Название работы | Автор | Дата защиты |

|---|---|---|

| Эквациональные LP-структуры и их приложения в системах переписывания | Баранов, Денис Владимирович | 2013 |

| Разработка методов поиска изображений на основе вычислительных моделей визуального внимания | Левашкина, Анастасия Олеговна | 2009 |

| Оценки вероятности переобучения многомерных семейств алгоритмов классификации | Ботов, Павел Валентинович | 2011 |